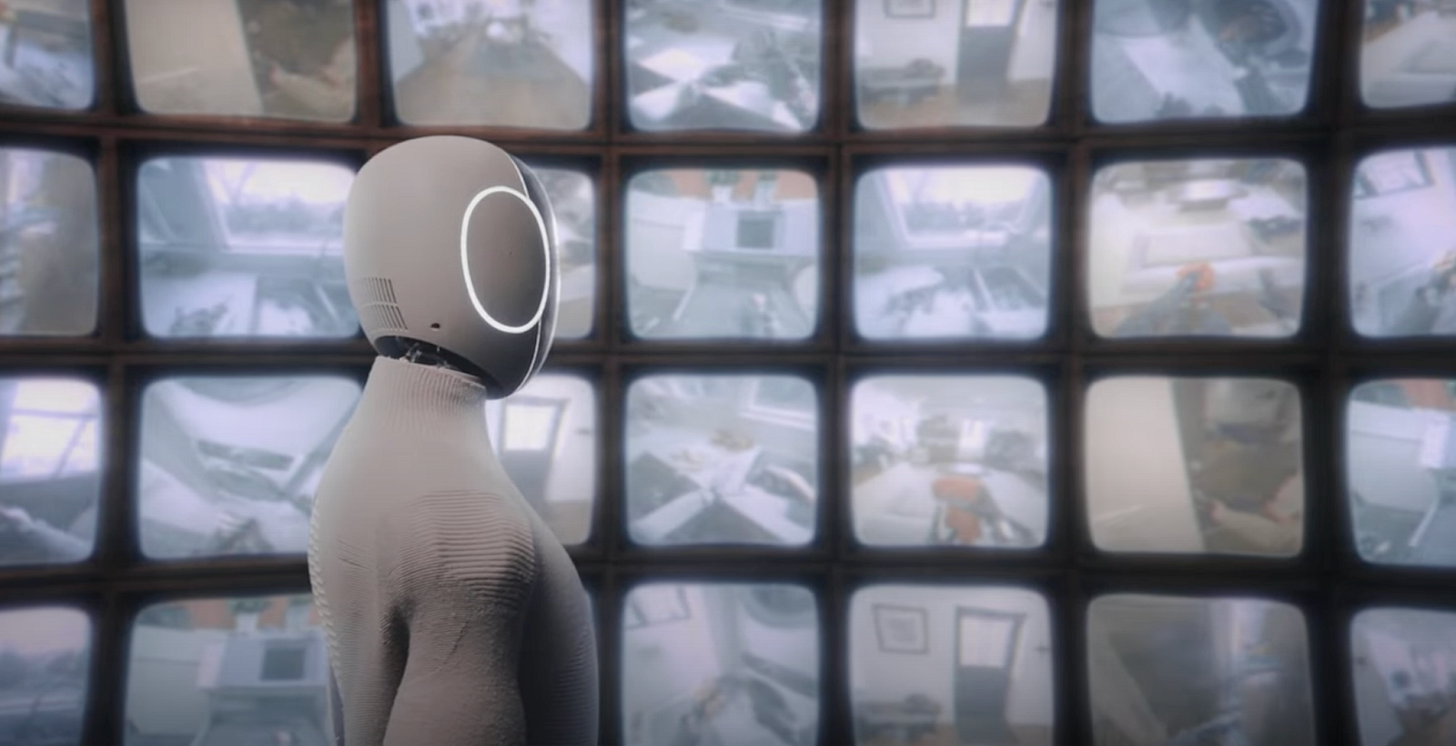

Los modelos fundacionales del mundo

El entrenamiento de la IA Física requiere de datos a través de los modelos del mundo

Cuando hablamos de software para robots deberíamos diferenciar entre tres tipos (por ahora) que permiten o permitirán en el futuro que estas máquinas acaben cumpliendo toda la función que esperamos de ellas. A saber:

⚙️ El software de control que sirve para que el robot se mueva y pueda cumplir la función que se le ha asignado. Aquí encontramos iniciativas destacadas como ROS a modo de framework para el desarrollo de software para robots.

👁️ El VLA que lo dota de inteligencia, lo cual es el equivalente a los LLM para los asistentes conversacionales, aunque en este caso se parece más a un modelo multimodal, ya que incorpora capacidad de visión y lenguaje, añadiendo la acción como tercer componente.

🌍 El modelo del mundo, que es a lo que dedicamos este artículo, y que sirve para el entrenamiento del robot, lo que le permite entender cómo funciona el mundo físico (rozamiento, gravedad, temperatura, humedad, distancia, …) en el que va a tener que realizar su función, con la ayuda de los dos anteriores.

Así que vamos a hablar de modelos del mundo, porque la noticia más novedosa es que Meta se ha metido en este negocio lanzado el modelo V-JEPA 2.

A saber, V-JEPA 2 es un modelo mundial con arquitectura predictiva que logra un rendimiento de vanguardia en comprensión visual y predicción en el mundo físico. Un modelo que ha sido entrenado a través de vídeos con 1.200 millones de parámetros y que puede utilizarse para la planificación de robots en modo “zero-shot” para interactuar con objetos desconocidos en nuevos entornos.

Atentos porque así explica el equipo de Meta AI, liderado por Yann LeCun, por qué son necesarios los modelos del mundo para que los robots lleguen a desenvolverse en la vida real de la misma forma que un agente lo hace en el mundo digital:

Todos sabemos que si lanzas una pelota de tenis al aire, la gravedad la tirará de ella hacia abajo. Sería sorprendente que flotara, girara repentinamente en el aire y saliera volando en otra dirección, o se transformara espontáneamente en una manzana. Ese tipo de intuición física no es algo que los adultos adquieran tras años de educación; los niños pequeños desarrollan esta intuición observando el mundo que los rodea incluso antes de poder formar frases completas. La capacidad de predecir cómo responderá el mundo a nuestras acciones (o a las de los demás) es algo que los humanos usamos constantemente, especialmente al planificar qué acciones tomar y cómo desenvolvernos mejor en situaciones nuevas. Nuestro modelo interno del mundo nos proporciona esta intuición y también actúa como un simulador interno, permitiéndonos predecir el resultado de una acción hipotética, para que finalmente podamos elegir la mejor acción según lo que creamos que nos permitirá lograr nuestro objetivo. Antes de actuar, utilizamos nuestro modelo de mundo para imaginar las posibles consecuencias.

Por lo tanto, el modelo del mundo desarrollado por Meta aporta a los robots las siguientes capacidades:

🧠 Comprensión: ser capaz de comprender observaciones del mundo, incluidas cosas como reconocer objetos, acciones y movimientos en un video.

🔮 Predicción: ser capaz de hacer predicciones sobre cómo evolucionará el mundo y cómo cambiará si el agente realiza una acción.

🗺️ Planificación: gracias a la capacidad de hacer predicciones, un modelo mundial debería ser útil para planificar secuencias de acciones que permitan lograr un objetivo determinado.

Interesante también fijarse en el plan de futuro de Meta con los modelos JEPA, ya que quieren centrarse en el entrenamiento de modelos jerárquicos capaces de aprender, razonar y planificar en múltiples escalas temporales y espaciales. Otra dirección importante serán los modelos multimodales que puedan realizar predicciones utilizando diversos sentidos, como la vista, el oído y el tacto.

Lo cual suena mucho a lo que son los VLA, por lo que vemos que en Meta están decididos en ir a fondo con el desarrollo de software de IA para robots. Una estrategia que se parece bastante a la adoptada por NVIDIA, donde tienen a Cosmos como modelo del mundo y a Isaac GR00T para el entrenamiento de robots humanoides con IA.

El modelo del mundo de 1X

Otra semana más toca hablar de 1X, ya que tras presentar su VLA llamado Redwood, ahora vuelve a ser noticia por la presentación de su modelo del mundo, que debe servir como puente entre los átomos y los bits.

El modelo del mundo es un gemelo digital del mundo real que predice las consecuencias futuras de las acciones del robot. Gracias a la utilización de una red neuronal generativa profunda se puede comprimir toda una vida en un segundo.

Este modelo del mundo creado por 1X busca abordar la complejidad del mundo real aprendiendo directamente de las grabaciones de miles de horas de interacción de robots capturadas a partir de datos sensoriales sin procesar. Esto permite modelar interacciones físicas complejas como el agarre de los objetos delicados, la previsión de colisiones entre cuerpos rígidos y la deformación de los objetos cuando son manipulados, lo cual aporta al modelo una comprensión profunda del funcionamiento de la física del mundo que nos rodea.

A medida que aumenta el entrenamiento y la correspondiente captación de datos, especialmente aquellos momentos en los que el robot falla en la ejecución de la tarea, se puede observar cómo la calidad del modelo va mejorando progresivamente. De esta forma, la empresa reconoce que los datos más valiosos para este entrenamiento son los obtenidos por el propio robot cuando se enfrenta a realizar una tarea de manera autónoma, aunque esta inicialmente sea fallida.

El modelo del mundo desarrollado por 1X visualiza continuamente los estados futuros, lo cual puede ser utilizado como núcleo cognitivo para el robot, de cara a planificar y ajustar dinámicamente sus acciones en función de los resultados previstos. Esta capacidad predictiva permite a Neo ejecutar tareas con mayor éxito, adaptarse mejor a los eventos inesperados, lo cual poco a poco le va a permitir convertirse en un robot de propósito general y verdaderamente inteligente.

La Inteligencia Espacial y el trabajo de Fei-Fei Li en World Labs

En 2007 Fei-Fei Li lideró el desarrollo de ImageNet, una enorme base de datos visual diseñada para impulsar el reconocimiento de objetos. El proyecto implicó el etiquetado de más de 14 millones de imágenes con Amazon Mechanical Turk e inspiró el desafío ILSVRC –ImageNet Large Scale Visual Recognition Challenge de reconocimiento visual a gran escala que impulsó el progreso en aprendizaje profundo y generó mejoras drásticas en el rendimiento de la clasificación de imágenes. La base de datos abordó un obstáculo clave en la visión artificial: la falta de grandes conjuntos de datos etiquetados para entrenar modelos de aprendizaje automático. Hoy en día, ImageNet se considera una innovación clave que sustenta los avances en vehículos autónomos, reconocimiento facial e imágenes médicas.

De hecho, el ganador del desafío ILSVRC en 2012 fue AlexNet, donde participaron Alex Krizhevsky (Google), Geoffrey Hinton (Google) y Ilya Sutskever (Google y OpenAI), una iniciativa que es puesta como ejemplo por parte de NVIDIA al respecto del inicio del uso de las GPU para el desarrollo de la Inteligencia Artificial Generativa.

Casi 20 años después de la aportación de ImageNet para el desarrollo de las tecnologías de visión artificial, Fei-Fei Li ha vuelto a la carga, en este caso para el impulso de la inteligencia espacial, que permitirá a las máquinas comprender e interactuar con el mundo que les rodea. Las personas usamos la inteligencia espacial para crear y plasmar imágenes en nuestra mente en el mundo físico. La usamos para razonar, movernos e inventar: para visualizar y diseñar cualquier cosa, desde humildes castillos de arena hasta imponentes ciudades.

El trabajo actual de Fei-Fei Li con World Labs quiere ir un paso más allá de las capacidades de los LLM, para el desarrollo de una IA con inteligencia espacial que pueda modelar el mundo y razonar sobre objetos, lugares e interacciones en el espacio y el tiempo 3D.

El modelo de generación de mundos de World Labs aún no ha mostrado aplicaciones en el ámbito de la robótica, pero qué duda cabe de que encaja muy bien con todo lo que hemos contado aquí de los modelos fundacionales del mundo, en una estrategia muy similar a la desarrollada hace décadas con ImageNet, así que habrá que estar muy atentos a su desarrollo.

Sam Altman predice que tendremos robots humanoides en 2027

Sam Altman se ha explayado en su blog hablando del desarrollo de la superinteligencia y dice que aunque los robots aún no caminan por las calles, hemos construido sistemas que son más inteligentes que las personas en muchos sentidos y capaces de amplificar significativamente el rendimiento de quienes los utilizan. Atentos a sus predicciones de futuro:

🧠 2025 llegaremos a agentes que pueden realizar trabajo cognitivo real

🧪 2026 probablemente llegaremos a sistemas capaces de descubrir nuevos conocimientos

🦾 2027 podremos ver la llegada de robots que puedan realizar tareas en el mundo real

"En la década de 2030, la inteligencia y la energía —las ideas y la capacidad de hacerlas realidad— serán inmensamente abundantes. Estas dos han sido los principales limitantes del progreso humano durante mucho tiempo; con inteligencia y energía abundantes (y un buen gobierno), teóricamente podemos tener cualquier otra cosa"

Más noticias sobre robótica e Inteligencia Artificial

🇸🇪AEON es el robot humanoide desarrollado por la empresa sueca Hexagon, en colaboración con NVIDIA, para satisfacer las necesidades reales de los clientes industriales y abordar la escasez de mano de obra.

🇨🇳 RoboBrain 2.0 es el modelo de IA para robots más potente desarrollado hasta la fecha por la Academia de Inteligencia Artificial de Beijing. Una nueva muestra del importante foco que tienen puesto en China en el desarrollo de los robots del futuro.

💰 Skild AI va a recibir pasta de Samsung y NVIDIA, en el marco de una ronda liderada por Softbank, que valora la empresa en 4500 millones de dólares. La startup ya contaba con Amazon como inversor y se dedica al desarrollo de software de IA para robots.

🇫🇷 Wandercraft anuncia su serie D por 75 millones de dólares. La empresa francesa comenzó fabricando exoesqueletos y ahora evoluciona para fabricar robots humanoides diseñados para las tareas industriales más duras y pesadas.

⛰️ Physical Intelligence propone el uso de fragmentación de acciones para la ejecución en tiempo real sin discontinuidades y de esta forma mejorar el funcionamiento de cualquier VLA basado en difusión o flujo, sin cambios en el tiempo de entrenamiento.