Gemelos digitales de robots

Mientras se avanza en el desarrollo de la parte física de los robots también hay mucho trabajo en su simulación virtual.

Escalar el entrenamiento de robots parece ser uno de los grandes retos que está afrontando con toda su energía la industria de la robótica y los avances están siendo muy importantes. Y aunque aún quede mucho por hacer, todo apunta a que se discurre en la dirección correcta que nos llevará a que se cumplan esas estimaciones tan ambiciosas de millones de robots trabajando por el mundo en los próximos años.

Pero para que esto ocurra va a ser necesario que siga produciéndose mucha investigación y que los fabricantes de robots las vayan incorporando, tanto a nivel de hardware, como de software, que es de lo que vamos a hablar hoy aquí.

Empecemos por presentar el proyecto RHyME que se está desarrollando en la Cornell University y propone un modelo llamado One-Shot Imitation under Mismatched Execution enfocado en que los robots puedan aprender determinados movimientos y tareas con ver una única vez un vídeo demostrativo donde una persona ejecuta la acción.

El concepto de One-shot imitation under mismatched execution nos explica que el robot sólo necesita ver una demostración del humano para aprender, aunque haya desajustes físicos o de estilo de movimiento. Por lo cual RHyME es un sistema que permite a los robots aprender a imitar lo que hace una persona en un vídeo, incluso si hay grandes diferencias entre el cuerpo del humano y el del robot (por ejemplo, una mano humana frente a una pinza robótica) o en cómo se mueven.

Esto nos hace plantearnos ¿por qué es tan difícil para los robots imitar a los humanos? y aquí es donde nos encontramos el desajuste de encarnación, porque el cuerpo del humano y el del robot no son iguales; los estilos de movimiento distintos, ya que un humano mueve la mano de una forma que el robot no puede imitar exactamente; y la falta de datos emparejados, porque es difícil tener un vídeo de un humano haciendo algo y otro del robot haciendo exactamente lo mismo para sincronizarlo.

En este caso RHyME no se necesita que el vídeo del humano y el del robot estén emparejados, sino que lo que hace es buscar partes del vídeo de humanos que tengan sentido para la tarea, unir esos trozos para crear un vídeo que represente bien la tarea y usar ese vídeo compuesto para entrenar al robot.

Otra iniciativa que vale la pena mencionar al respecto de cómo se está creando software para el entrenamiento de robots es Reborn, que hemos conocido a través del anuncio de la colaboración con Booster Robotics para trabajar juntos en el desarrollo de robots humanoides, aportando la primera su plataforma descentralizada para la generación de datos de robots humanoides y la segunda sus pequeños robots con un enfoque a la demostración de habilidades físicas en el ámbito del deporte.

A través de esta colaboración Reborn proporcionará a Booster:

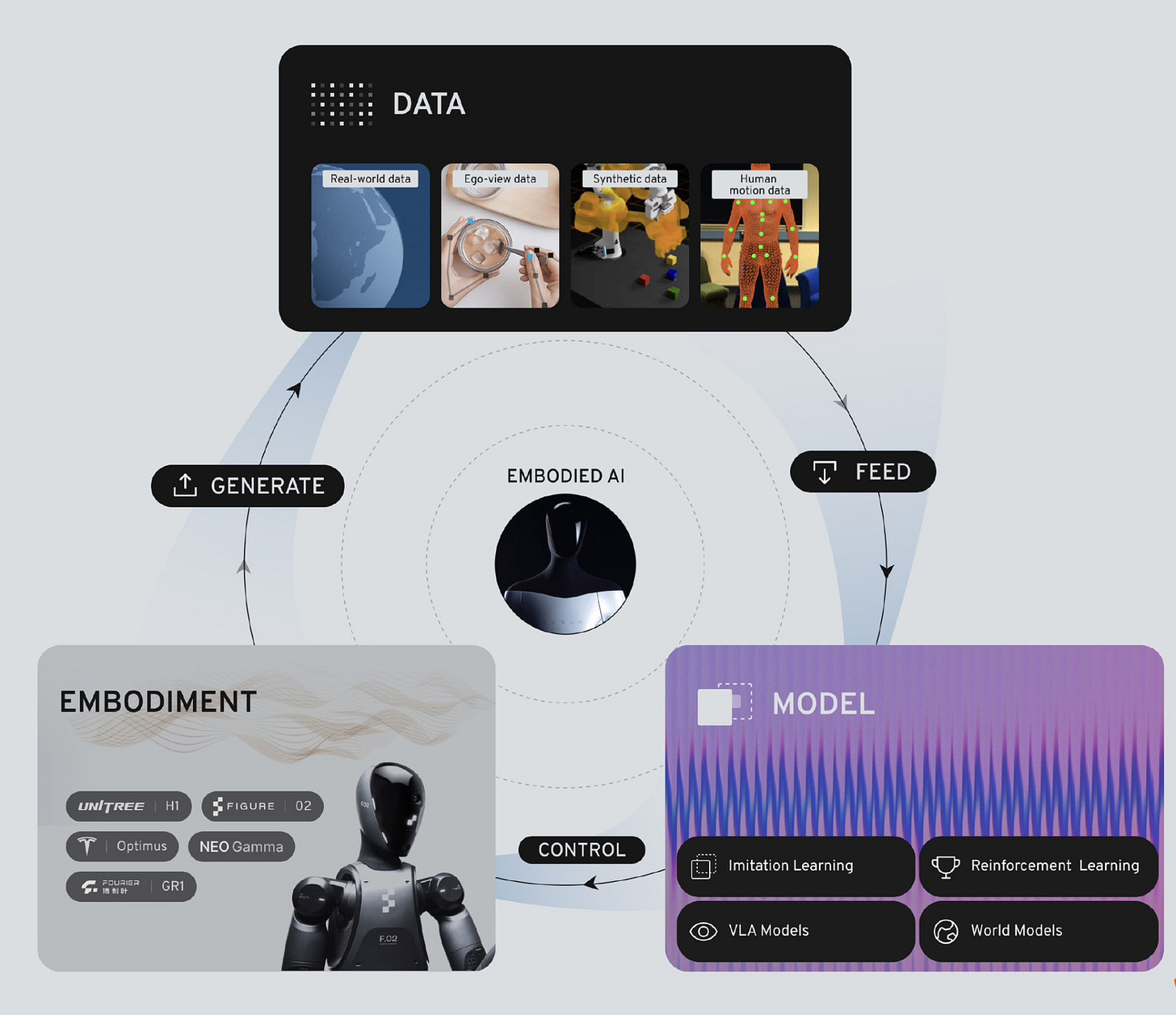

Datos de movimiento humano a gran escala, que recopilan mediante un proceso híbrido entre Rebocap™ y la plataforma de juegos de realidad virtual Reborn. Rebocap captura el movimiento corporal completo con alta fidelidad, mientras que la realidad virtual proporciona datos detallados de manipulación manual. Este diverso conjunto de datos permite el aprendizaje por imitación escalable en tareas del mundo real como caminar, agarrar, ensamblar y usar herramientas.

Datos de simulación sintética respaldados por Roboverse que Booster Robotics podrá usar y que incluyen miles de comportamientos humanoides generados procedimentalmente, como caminar, mantener el equilibrio, sortear obstáculos y manipular objetos complejos. Estos datos han sido creados en entornos de física de alta fidelidad con información etiquetada de articulaciones y tareas. Recursos que reducen las barreras de entrenamiento para las habilidades motoras fundamentales de los robots.

Servicios versátiles de modelos de IA desarrollados internamente para humanoides, que incluyen control corporal completo, visión-lenguaje-acción (VLA) y agarre manual diestro.

Todo esto nos lleva a profundizar en el concepto de gemelos digitales aplicados para el desarrollo de la robótica, una técnica que ya es ampliamente usada en el ámbito de la industria en general, pero que toma especial importancia cuando hablamos de robots humanoides por la enorme complejidad que estos presentan de cara a satisfacer las expectativas que se esperan de su trabajo.

Un gemelo digital es una réplica virtual de un sistema físico, en este caso, un robot humanoide, que nos permite simular en tiempo real su comportamiento, entorno y procesos internos. Para ello se nutre de datos del mundo real y modelos de IA para predecir, diagnosticar y optimizar el rendimiento del robot antes de ejecutar acciones en el mundo físico.

De esta forma, los gemelos digitales permiten entrenar y probar algoritmos de control y percepción sin el riesgo físico que implica que el robot actúa realmente sin estar muy pulida su programación, lo cual facilita el desarrollo de robots humanoides más seguros, eficientes y adaptativos.

Los gemelos digitales también se pueden usar para monitorizar el estado del robot, detectar fallos antes de que ocurran y optimizar sus tareas en entornos reales. De esta forma vemos que los gemelos digitales se empiezan a integrar con los modelos de IA generativa y los modelos predictivos, permitiendo que los robots humanoides aprendan en entornos virtuales antes de actuar en el mundo real. Esta capacidad reducirá costes, acelerará el despliegue y aumentará la fiabilidad de estas máquinas en todo tipo de actividades y entornos.

Y a para terminar, veamos algunos ejemplos de cómo diferentes empresas están contribuyendo al desarrollo de los robots humanoides a través de simuladores y gemelos digitales:

Genie 2 de Deepmind es un un modelo del mundo capaz de generar una variedad infinita de entornos 3D jugables y controlables por acción para entrenar y evaluar agentes encarnados, entre los que ya sabemos que se encuentran los robots, como ha explicado recientemente Demis Hassabis en una entrevista.

Cosmos de NVIDIA es una plataforma de modelos de mundo generativos (WFM), tokenizadores avanzados, barreras de protección y una canalización acelerada de procesamiento y selección de datos construida para acelerar el desarrollo de la IA física, en tecnologías como los vehículos autónomos y los robots.

Reachy2 de Pollen, ahora propiedad de Hugging Face, nos ofrece un simulador en Docker para poder usar un gemelo digital del robot, de cara a poder educativo, demostración, prueba o desarrollo.

Otras noticias destacadas sobre Robótica e Inteligencia Artificial

🇰🇷 K-Humanoid Alliance es la iniciativa de investigación y desarrollo de robots humanoides formada por instituciones, universidades y fabricantes, que nos muestra que en Corea del Sur van muy en serio con esta tecnología.

🏃 Tiangong ganó la media maratón de Pekín con un tiempo de 2 horas y 40 minutos, más del doble del tiempo del ganador de la carrera humana. El robot fue construido por el Centro de Innovación de Robots Humanoides de Pekín.

🐽 Ainose es una empresa que ha desarrollado una tecnología de digitalización de olores que permite a los robots tener sentido del olfato, por ejemplo para detectar fugas de gas antes de que los humanos puedan hacerlo.

🦾 XPENG comienza a mostrar al público su robot humanoide Iron. Su director ejecutivo, He Xiaopeng, ha revelado sus planes de invertir hasta 13.800 millones de dólares en el sector durante los próximos 20 años.

💻 Huawei ha presentado el chip de IA 910C que alcanza un rendimiento comparable al del chip H100 de NV al combinar dos procesadores 910B en un solo encapsulado mediante técnicas de integración avanzadas.

Q-CTRL es un fabricante de software de infraestructura cuántica que ha anunciado la exitosa demostración de su nuevo sistema de navegación cuántica llamado Ironstone Opal que es 50 veces más preciso que el GPS.